NICがたくさんあって、そこそこ省エネが期待できるUTMのXG-135にESXiを入れたときの記録です。

インストールしようとすると、RMRR overlaps system memoryでPSoDになったりしたので、回避策をさがしました。

続きを読むNICがたくさんあって、そこそこ省エネが期待できるUTMのXG-135にESXiを入れたときの記録です。

インストールしようとすると、RMRR overlaps system memoryでPSoDになったりしたので、回避策をさがしました。

続きを読む今度はPacemakerを使ってみようと思います。

続きを読むHW周りを変更して、同期は専用のNICを使うように構成変更します。

続きを読む自宅のシステムはiSCSIのディスクが単一障害点になっています。

共有ディスクに関しては冗長化するのは難しいと思っていましたが、DRBD+Keepalived +NFSを用いてESXiで使える冗長化共有ディスクを試してみようと思います。

以前まではRyzen 5 2600を仮想化サーバにしてましたが、DL360pGen8に更新したので備忘録です。

自作PCをESXiのサーバにしているとHWのステータスが取れないとか、IPMIがないので管理が大変だったりします。

※Supermicroとか買えばIPMIとかついてたりしますけどね

HPEのサーバであるDL360p Gen8が安かったので、リプレースしました。世代的には前に戻る形になりますが……。

HPのサーバは以前にML150 G6を持ってたのですが、騒音的にはなかなかの物で、避けてきましたが、Gen8からは静かとも聞いたの手を出してみました。

実際のところ1Uサーバですが、Fanが20%で回ってる分には気にならない程度です。

このサーバを中心に仮想環境を更新しているので、ブログも合わせて書いていこうと思います。

まずはHWまわりの部分に関して増設は以下の通りです。同じ構成で2台動かしてます。

こだわりポイントは増設カードを純正で固めてるところです。HPEのサーバは純正以外のカードを使うとファンコントロールが効かなくなることがあるらしいので、NICに至っても純正を手配しました。

6.0まではC#クライアントが使えてそこから設定できたのですが、6.5以降はWebのみになり、設定ができなくなったのでコマンドの備忘録です。

SSH接続を有効にする or コンソールシェルで操作します。

とりあえずデバイス一覧を出します。

[root@localhost:~] esxcli storage nmp device list

naa.6001405e38e9c74a09c4962819b88603

Device Display Name: LIO-ORG iSCSI Disk (naa.6001405e38e9c74a09c4962819b88603)

Storage Array Type: VMW_SATP_ALUA

Storage Array Type Device Config: {implicit_support=on; explicit_support=on; explicit_allow=on; alua_followover=on; action_OnRetryErrors=on; {TPG_id=0,TPG_state=AO}}

Path Selection Policy: VMW_PSP_RR

Path Selection Policy Device Config: {policy=rr,iops=1000,bytes=10485760,useANO=0; lastPathIndex=1: NumIOsPending=1,numBytesPending=512}

Path Selection Policy Device Custom Config:

Working Paths: vmhba64:C0:T0:L1, vmhba64:C2:T0:L1

Is USB: false

naa.6001405cbaeb08b93c340679108942c9

Device Display Name: LIO-ORG iSCSI Disk (naa.6001405cbaeb08b93c340679108942c9)

Storage Array Type: VMW_SATP_ALUA

Storage Array Type Device Config: {implicit_support=on; explicit_support=on; explicit_allow=on; alua_followover=on; action_OnRetryErrors=on; {TPG_id=0,TPG_state=AO}}

Path Selection Policy: VMW_PSP_RR

Path Selection Policy Device Config: {policy=rr,iops=1000,bytes=10485760,useANO=0; lastPathIndex=0: NumIOsPending=0,numBytesPending=0}

Path Selection Policy Device Custom Config:

Working Paths: vmhba64:C0:T0:L0, vmhba64:C2:T0:L0

Is USB: false

Path Selection Policy: VMW_PSP_RRとなっている場所がパス選択ルールになります。内容は以下の通りです。

そして変更は次のようにします。

esxcli storage nmp device set -d naa.6001405e38e9c74a09c4962819b88603 -P VMW_PSP_RR

IBM System X3650 M2とX3250 M4にInfiniBandを搭載しました。

MHQH19B-XTR(ConnectX-2)というInfiniBandのHCAが安くで入手できたので、仮想サーバとiSCSIサーバに搭載です。HCAはすごく安かったのですが、QSFPケーブルが必要だったので、次のケーブルを買いました。 (HCA2個よりケーブル1Mのほうが高かった)

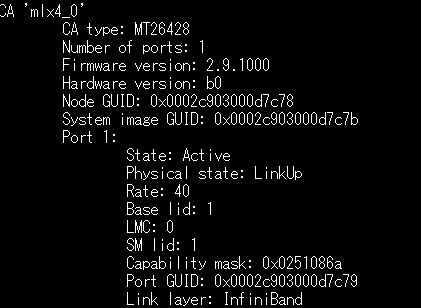

X3250 M4でibstatしたところ、InfiniBandでRate 40でリンクされています。

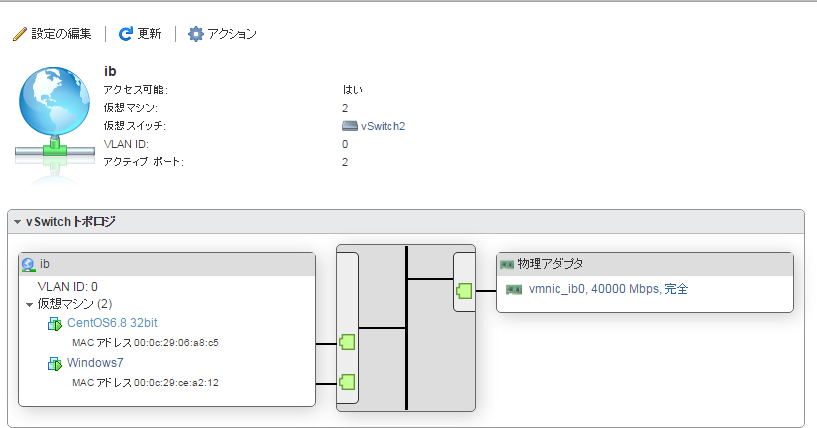

ESXi側の認識では物理アダプタ側は40000Mbps(40Gbps)でリンクされています。

ESXiはドライバをメーカーのものを組み込まないとリンクできませんでした。

ねころくぶろぐ様を参照してドライバを組み込んだらうまくいきました。

https://www.neko6.info/archives/2100

8Gbpsちょい出ています。仮想マシンにNICを追加するときに10Gbpsまでしか認識しないようです。

せっかくここまで速度の出るLANを用意しましたが、あんまり使いみちは無いんですよね・・・

X3250 M4にSSDを積んでiSCSIをInfiniBand経由にしたら爆速になったりするんでしょうか?

まず、現在のサーバ環境をざっくり画像で紹介します。

X3250 M4にST3250824ASという何の変哲も無い3.5インチのSATA HDDを搭載、iSCSIターゲットを構築し、ESXiでデータストアとして使用します。

X3250 M4上でhdparm -t をしてみたところ61MB/sと昔のHDDらしい読み込み速度でした。

一方で、X3650 M2のESXi上でiSCSIにおいてあるマシンでhdparmをするとこのような結果になりました。

iSCSIには192.168.3.x系ネットワークでESXiとiSCSIターゲットを1GbpsのLANで直接つないでいます。

このような結果になった理由はわかっていませんが、iSCSIでStorageを構成するのはアリなのかな?